大家应该看过一些元首恶搞视频吧,利用一些名场景搭配上恶搞的台词可以生成很多鬼畜视频。但是这些视频的嘴型和实际说出的台词是对应不上的。如果可以对应上会不会更加真实有趣呢?Wav2lip这个基于图像生成模型(GAN)的新技术就是希望达到这一目的。

那么这个技术是如何生成嘴型同步的视频的呢?我们之前介绍GAN的时候有提到过,GAN在训练时有生成器和判别器共同对抗训练。生成器用于生成尽可能接近真实的数据,从而欺骗判别器,而判别器用于判断给定数据是真实的还是生成的,从而迫使生成器生成更加高质量的逼真数据。

在wav2lip中,判别器除了对比和真实数据的直接差距之外,引入了一个训练好的唇形同步模型(Lip-sync expert)。这个所谓的唇形同步模型是计算音频和嘴型之间的同步程度的,通常用在音视频流的对齐上,也可以在包含多人的视频场景中准确定位正在说话的人。Wav2lip的作者认为,通常的基于像素点计算的重建误差对嘴唇的同步情况判断非常糟糕,故引入了预训练的唇形同步模型去判断生成器生成的视频结果中人物的嘴型和声音是否匹配。A lip-sync expert is all you need!此外,作者还增加了和视频画面质量相关的指标同样也作为判别器的判定标准,于是在严格的判别器的push之下,生成器终于学会了生成高质量的、嘴型准确的视频了!

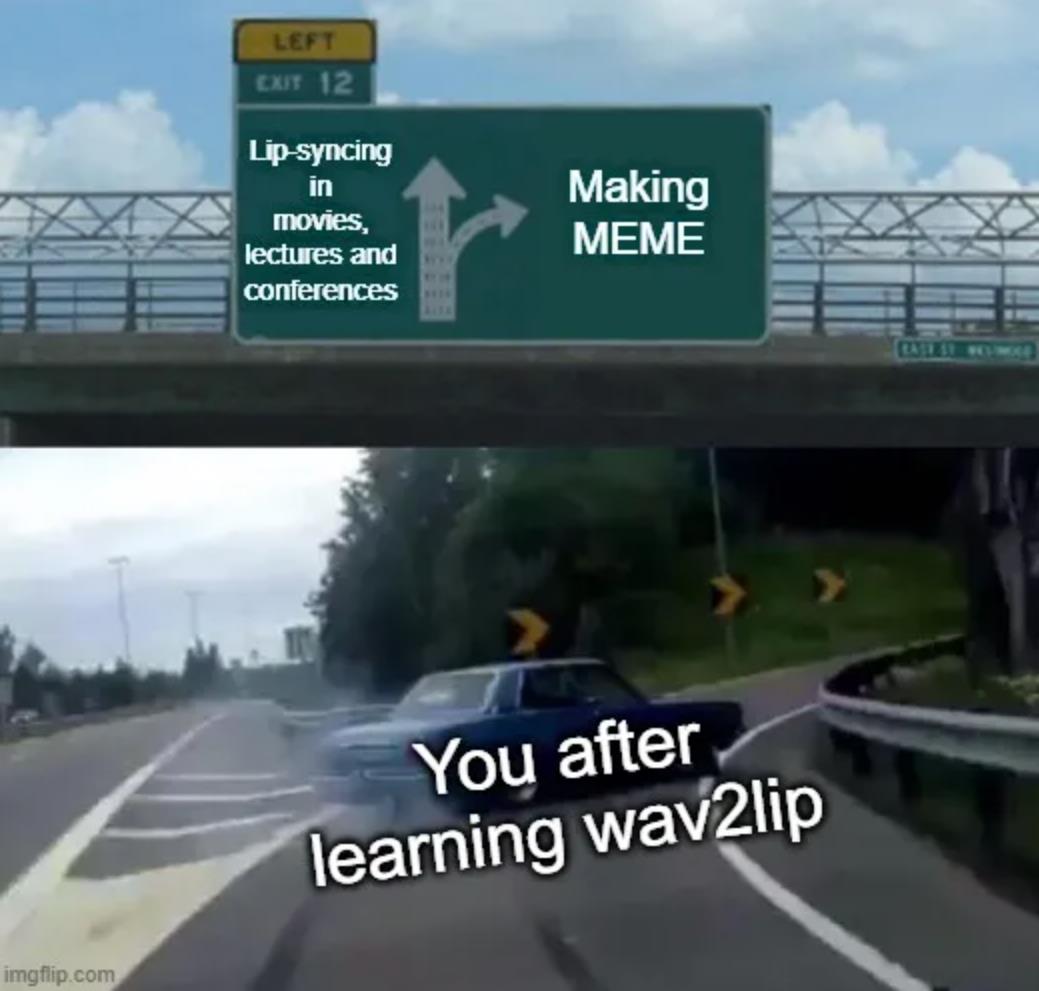

这个技术可以用在很多方面,例如给译制的电影重新配音时修改演员的嘴型,修改会议中同步传译的演讲人嘴型,或者用于辅助制作CG动画等。当然大家喜闻乐见的还是制作各种梗图啦,作者提供了非常方便的制作网站,大家可以去体验一下~

DEMO体验(可点击阅读原文跳转):

https://bhaasha.iiit.ac.in/lipsync

论文地址:

https://arxiv.org/abs/2008.10010

GitHub项目链接:

https://github.com/Rudrabha/Wav2Lip

了解GAN是如何工作的:

Lip-sync expert: